Meta-metody klasyfikacji

W tym tygodniu poznajemy meta-metody uczenia maszynowego. Dowiadujemy się, czy bezpośrednia demokracja (Voting) jest lepsza niż demokracja sterowana (Stacking) i dowiadujemy się, jak zastosować klasyfikator binarny do klasyfikacji danych zawierających więcej niż dwie klasy. A przede wszystkim uczymy się oszczędzać sobie czas wykonując setki eksperymentów za jednym pociągnięciem myszki.

Scikit Learn

- Pobierz notatnik ed-ensemble.ipynb i uruchom go w środowisku Jupyter Lab

Rapid Miner

- Uruchom narzędzie Rapid Miner

- Utwórz przepływ ilustrujący metodę Bagging. W tym celu załaduj pobierz zbiór nursery.arff i prześlij do operatora

Set Role, wskazując atrybut class jako zmienną celu. Następnie prześlij zbiór danych do operatoraSplit dataw celu podzielenia zbioru na dwie partycje w proporcji 70%-30%. Prześlij większą część zbioru uczącego do operatoraBagging. Wykonaj 10 iteracji uczenia drzewa decyzyjnego, wykorzystując w każdej iteracji 90% danych jako zbiór uczący. Model wynikowy wyślij do operatoraApply Modela jako zbiór testowy wykorzystaj owe 30% oryginalnych danych które nie było wykorzystywane do uczenia klasyfikatora. Wykorzystaj operatorPerformancedo znalezienia dokładności klasyfikatora końcowego. Sprawdź, jaki wpływ na dokładność klasyfikacji ma zmieniająca się liczba iteracji (tj. niezależnie budowanych modeli). - Utwórz przepływ wykonujący algorytm AdaBoost. Pobierz zbiór danych arrhythmia.arff i za pomocą operatora

Set Rolewskaż atrybut class jako zmienną decyzyjną. Prześlij zbiór danych do operatoraSplit Validationpozostawiając domyślne parametry tego operatora. W fazie uczenia operatoraSplit Validationumieść meta-operatorAdaBoost, a wewnątrz tego operatora umieść algorytm k-NN (użyj dowolnej liczby sąsiadów, ale zaznacz ważenie instancji). W fazie testowania operatoraSplit Validationumieść tradycyjnie operatoryApply ModelorazPerformancew celu określenia dokładności klasyfikacji. Porównaj uzyskany wynik z sytuacją w której zamiast operatoraAdaBoostwykorzystujesz bezpośrednio k-NN. - Pobierz zbiór danych breast-cancer.arff (zmienną decyzyjną jest Class. Utwórz przepływ realizujący proste głosowanie. Wyślij dane do operatora

Split Datai podziel je w proporcji 70%-30%. Większy zbiór prześlij do operatoraVote, wewnątrz którego umieść klasyfikatoryCHAID,Naive Bayes Classifierorazk-NN. Model wynikowy wyślij do operatoraApply Modela jako zbiór testowy wykorzystaj dane nieużyte do uczenia klasyfikatorów. Jaka jest dokładność takiego klasyfikatora? Czy jest on lepszy niż indywidualne klasyfikatory? - Zamień głosowanie na operator

Stacking, umieszczając w fazie Stacking Model Learner operatorRule Induction. Uruchom przepływ i obejrzyj modele bazowe. Czy operatorStackingwygenerował lepszy model niżVoting? - W ostatnim przykładzie postaramy się przeszukać przestrzeń parametrów w celu znalezienia optymalnych wartości. Pobierz ponownie zbiór letter.arff i prześlij go do operatora

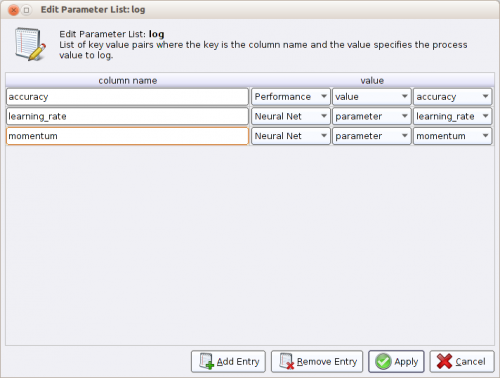

Optimize Parameter (Grid), wcześniej wskazując atrybut class jako zmienną celu. Wewnątrz operatora umieść operatorSplit-Validationzawierający w fazie uczenia operatorNeural Net, a w fazie testowania tradycyjną kombinację operatorówApply ModeliPerformance (Classification). Port wyjściowy ave operatoraValidationprześlij do operatoraLogi zapisz pod dowolną nazwą na dysku. W konfiguracji operatoraLogzaznacz zapisywanie dokładności (wartość z operatoraPerformance), momentu (parametr z operatoraNeural Net) i tempa uczenia (parametr z operatoraNeural Net). Konfiguracja operatoraLogpowinna wyglądać następująco:

- Wróć do konfiguracji operatora

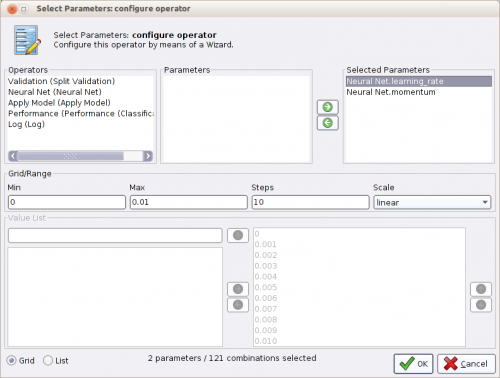

Optimize Parameter (Grid). Kliknij przycisk Edit Parameter Settings i z listy dostępnych operatorów wybierz operatorNeural Net, a następnie wybierz dwa parametry operatora:learning_rateimomentum. Przenieś oba parametry do panelu Selected Parameters. Zaznacz parametrlearning_ratei wskaż, że powinien się zmieniać od 0 do 1 w 4 krokach. Analogicznie, skonfiguruj parametrmomentumaby się zmieniał od 0 do 1 w 4 krokach (w obu przypadkach zwiększanie wartości parametru w każdym kroku powinno być liniowe). Okno konfiguracji operatoraOptimize Parameter (Grid)powinno wyglądać następująco:

- Przejdź jeszcze do konfiguracji operatora

Neural Net. Ustaw liczbę cykli uczenia sieci na 5. Wyłącz także normalizację i mieszanie danych wejściowych. Uruchom przepływ a następnie skorzystaj z wizualizacji Surface 3D w celu obejrzenia wyników.

Except where otherwise noted, content on this wiki is licensed under the following license:Public Domain