Drzewa decyzyjne

Celem laboratorium jest zapoznanie studentów z podstawowymi metodami indukcji drzew decyzyjnych.

Rapid Miner

- Uruchom narzędzie RapidMiner

- Utwórz prosty przepływ polegający na wczytaniu zbioru danych bank.csv i uruchomieniu operatora

Decision Stump. Obejrzyj uzyskany model. Sprawdź, w jaki sposób zmiana kryterium podziału zbioru wpływa na kształt modelu. Zamień operatorDecision Stumpna operatorDecision Treei ponownie zbuduj oraz przeanalizuj model. Następnie wyłącz pre- i post-processing i sprawdź, jaki wpływ miało to na kształt modelu - Dodaj do przepływu dyskretyzację atrybutów (operator

Discretize, podział na 3 przedziały), oraz zmień operatorDecision Treena kolejno:CHAID,ID3, orazDecision Tree (weight-based). W ostatnim przypadku jako operator wewnętrzny do ważenia atrybutów wykorzystaj operatorWeight by Correlation. - Utwórz nowy przepływ zawierający operatory

Read ARFF(wczytaj plik mushroom.arff),Set Role(wskaż atrybutclassjako typulabel),Replace Missing Values(pozostaw domyślne parametry), oraz uruchom proces walidacji krzyżowej wykorzystując operatorCross-Validate. Jako operatory wewnętrzne walidacji zastosuj najpierwDecision Tree, a potemRandom Forest. Zaobserwuj zmiany w generowanych modelach, zwróć uwagę, jaki wpływ na model losowy ma zwiększenie puli dostępnych atrybutów.

- Uruchom narzędzie RapidMiner i załaduj zbiór fertility.csv. Zapoznaj się z opisem zbioru danych.

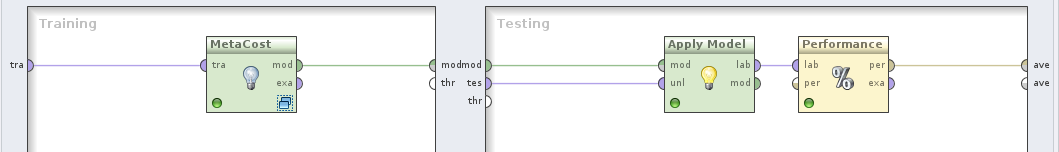

- Utwórz przepływ w którym za pomocą walidacji krzyżowej ocenisz jakość modelu drzewa decyzyjnego. Jako miarę oceny podziału przyjmij miarę

gini_index. Obejrzyj uzyskany model i macierz pomyłek. Czy model dobrze radzi sobie z rozpoznawaniem nietypowych próbek? - Przyjmij, że klasą pozytywną są normalne próbki spermy. Umieść operator

Decision Treewewnątrz operatoraMeta Costi zbuduj macierz kosztów, w którym błąd false positive będzie dwukrotnie droższy niż błąd false negative. Obejrzyj uzyskaną macierz pomyłek. - Postaraj się uzyskać rozwiązanie, w którym czułość klasy “O” (ang. recall) przekroczy 50%. Co dzieje się z ogólną dokładnością klasyfikatora?

- Zamień operator

Decision TreenaRandom Treei skonfiguruj operator w taki sposób, aby w każdej iteracji dysponował połową atrybutów do wyboru. Ponownie postaraj się tak skonfigurować macierz kosztów, aby uzyskać czułośc klasy “O” powyżej 50% przy jak najwyższej ogólnej dokładności modelu. - Zamień operator

Meta Costna operatorTree to Rulespozostawiając wewnątrz indukcję drzewa decyzyjnego przy użyciu miarygini_index. Obejrzyj uzyskany model regułowy.

Orange Data Mining

- Użyj operatora

Select Attributesdo wskazania, który atrybut jest zmienną celu. - Użyj operatora

Edit Domainaby wartościom zmiennej celu nadać czytelne nazwy - Postaraj się zbudować jak najdokładniejszy klasyfikator który umożliwia przewidywanie dominującej religii w państwie na podstawie cech charakterystycznych flagi tego państwa.

- Prześlij dane do operatora

Test Learnersi skonfiguruj operator w taki sposób, aby ocena modeli odbywała się na podstawie walidacji krzyżowej. - Wykorzystaj jednocześnie: głosowanie większościowe, naiwny klasyfikator Bayesa, drzewo decyzyjne i klasyfikator regułowy. Obejrzyj tablicę z sumarycznymi wynikami. Czym różnią się od siebie poszczególne klasyfikatory?

- Wyślij wszystkie klasyfikatory do operatora

ROCi obejrzyj uzyskane krzywe.

Except where otherwise noted, content on this wiki is licensed under the following license:Public Domain